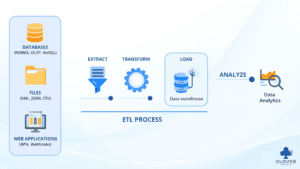

فرآیند ETL (Extract, Transform, Load) یکی از مهمترین فرآیندها در مدیریت دادهها و انبارهای دادهها است. هر بخش این فرآیند نقش مهمی در جمعآوری، آمادهسازی و بارگذاری دادهها ایفا میکند. در ادامه، هر بخش از فرآیند ETL را با جزئیات، اعم از چالشها و ابزارها را مفصل توضیح میدهیم:

1. مرحله اول – استخراج (Extract)

مرحله استخراج (Extract) اولین و مهمترین بخش از فرآیند ETL است. در این مرحله، دادهها از منابع مختلف جمعآوری میشوند و به محیطی منتقل میشوند که بتوانند در آن پردازش شوند. هدف اصلی این مرحله، جمعآوری دادههای خام به صورتی است که برای مراحل بعدی (تبدیل و بارگذاری) قابل استفاده باشد.

مراحل و وظایف اصلی در مرحله استخراج:

شناسایی منابع داده

در ابتدا باید منابع دادهای که اطلاعات مورد نیاز در آنها ذخیره شدهاند، شناسایی شوند. این منابع میتوانند شامل موارد زیر باشند:

- دیتابیسهای رابطهای (Relational Databases): مانند MySQL، PostgreSQL، Oracle، SQL Server

- دیتابیسهای غیر رابطهای (NoSQL Databases): مانند MongoDB، Cassandra

- فایلهای فلت (Flat Files): مانند فایلهای CSV، Excel

- APIها: منابع دادهای که از طریق وب سرویسها (RESTful APIs) ارائه میشوند.

- سیستمهای ERP: سیستمهای برنامهریزی منابع سازمانی که شامل دادههای مهم تجاری هستند.

- دادههای ابری (Cloud Data): دادههایی که در سرویسهای ابری مانند AWS، Google Cloud یا Azure ذخیره شدهاند.

اتصال به منابع داده

پس از شناسایی منابع داده، باید به این منابع متصل شد. این کار از طریق استفاده از اتصالات و پروتکلهای مناسب انجام میشود:

- اتصالات دیتابیس: مانند JDBC یا ODBC برای اتصال به دیتابیسهای رابطهای.

- اتصالات فایل: برای دسترسی به فایلهای فلت.

- اتصالات وب سرویس: برای ارتباط با APIها.

استخراج دادهها

در این مرحله، دادهها از منابع مختلف استخراج میشوند. این فرآیند ممکن است شامل تکنیکهای مختلفی باشد:

- استخراج مستقیم: انتقال مستقیم دادهها از دیتابیسهای رابطهای به محیط پردازش.

- اسکرپینگ وب (Web Scraping): استخراج دادهها از وبسایتها با استفاده از تکنیکهای اسکرپینگ.

- استخراج از فایلها: خواندن دادهها از فایلهای فلت و انتقال آنها به محیط پردازش.

مدیریت تغییرات دادهها (CDC – Change Data Capture)

برای اطمینان از بهروزرسانی مداوم و دقیق دادهها، روشهایی برای شناسایی و مدیریت تغییرات دادهها استفاده میشود. این شامل شناسایی تغییرات جدید در دادهها و استخراج آنها به طور منظم است.

زمانبندی و اتوماسیون

برای اطمینان از اینکه فرآیند استخراج به صورت منظم و به موقع انجام میشود، زمانبندی و اتوماسیون فرآیندها ضروری است. این کار از طریق ابزارهای ETL و زمانبندهای شغلی (Job Schedulers) انجام میشود.

شما میتوانید مقاله جمعآوری داده Data Collection را برای درک بیشتر این مطالب نیز مطالعه بفرمایید.

چالشهای مرحله استخراج

- حجم بالای دادهها: استخراج حجم زیادی از دادهها میتواند زمانبر و پیچیده باشد.

- کیفیت دادهها: دادههای استخراجشده ممکن است نواقص، خطاها و ناسازگاریهایی داشته باشند که باید در مراحل بعدی برطرف شوند.

- پراکندگی منابع داده: دادهها ممکن است در منابع مختلف و پراکنده ذخیره شده باشند که فرآیند استخراج را پیچیدهتر میکند.

- مسائل امنیتی: دسترسی به منابع دادهای باید با رعایت پروتکلهای امنیتی و حریم خصوصی انجام شود.

نقش کلاور در مرحله استخراج

- شناسایی منابع داده: تحلیلگر داده باید منابع دادهای مختلف را شناسایی کند که اطلاعات مورد نیاز را در اختیار دارند.

- طراحی فرآیند استخراج: تحلیلگر داده باید فرآیند استخراج را طراحی کند تا دادهها به صورت کارآمد و موثر جمعآوری شوند.

- نظارت بر کیفیت دادهها: تحلیلگر داده باید اطمینان حاصل کند که دادههای استخراج شده کیفیت مطلوبی دارند و برای مراحل بعدی مناسب هستند.

- مستندسازی: تحلیلگر داده باید فرآیندها و تکنیکهای استفاده شده در مرحله استخراج را مستندسازی کند تا در آینده قابل استفاده و بررسی باشند.

به طور کلی، مرحله استخراج یکی از کلیدیترین مراحل در فرآیند ETL است که تضمین میکند دادهها به صورت صحیح و کامل از منابع مختلف جمعآوری شده و برای پردازشهای بعدی آماده میشوند.

2. مرحله دوم – تبدیل (Transform)

مرحله تبدیل (Transform) دومین و مهمترین بخش از فرآیند ETL (Extract, Transform, Load) است. در این مرحله، دادههای خام استخراجشده به فرمتها و ساختارهایی تبدیل میشوند که برای تجزیه و تحلیل و استفادههای عملیاتی مناسب باشند. هدف اصلی این مرحله، تمیز کردن، غنیسازی و تبدیل دادهها به شکلی است که با نیازهای تجاری و تحلیلی سازمان سازگار باشد.

مراحل و وظایف اصلی در مرحله تبدیل:

-

تمیز کردن دادهها (Data Cleaning)

دادههای خام معمولاً دارای نواقص، خطاها و ناسازگاریهایی هستند که باید در این مرحله برطرف شوند.

وظایف اصلی در تمیز کردن دادهها:

-

- حذف دادههای تکراری: شناسایی و حذف رکوردهای تکراری.

- تکمیل دادههای ناقص: پر کردن مقادیر مفقود شده یا جایگزینی آنها با مقادیر پیشفرض.

- اصلاح خطاها: تصحیح خطاهای تایپی، فرمتهای نادرست و دیگر خطاهای دادهای.

- استانداردسازی: تبدیل دادهها به فرمتها و استانداردهای یکسان (مثلاً فرمتهای تاریخ).

برای کسب اطلاعات بیشتر به مقاله پاکسازی و پیشپردازش دادهها مراجعه فرمایید.

-

تبدیل فرمت دادهها (Data Transformation)

در این مرحله، دادهها به فرمتها و ساختارهای مناسب تبدیل میشوند تا بتوانند در سیستمهای مختلف و برای تحلیلهای مختلف استفاده شوند.

وظایف اصلی در تبدیل فرمت دادهها:

-

- تبدیل نوع دادهها: تغییر نوع دادهها (مثلاً تبدیل رشته به عدد).

- تبدیل واحدها: تبدیل واحدهای اندازهگیری به واحدهای استاندارد.

- محاسبات و تغییرات: انجام محاسبات پیچیده، مانند محاسبه میانگین، مجموع و سایر محاسبات آماری.

-

تجمیع دادهها (Data Aggregation)

تجمیع دادهها به معنای جمعآوری و ترکیب دادهها از منابع مختلف برای ایجاد یک دیدگاه یکپارچه و جامع است.

وظایف اصلی در تجمیع دادهها:

-

- جمعآوری دادهها: ترکیب دادهها از منابع مختلف.

- خلاصهسازی: خلاصه کردن دادهها به منظور کاهش حجم و افزایش کارایی.

- ایجاد شاخصها: محاسبه شاخصها و متریکهای کلیدی برای تحلیلهای بعدی.

-

غنیسازی دادهها (Data Enrichment)

در این مرحله، دادههای موجود با دادههای اضافی و مفید غنیسازی میشوند تا ارزش آنها افزایش یابد.

وظایف اصلی در غنیسازی دادهها:

-

- پیوند دادهها: افزودن اطلاعات از منابع خارجی به دادههای موجود.

- افزودن متادادهها: افزودن اطلاعات توصیفی به دادهها.

- دستهبندی: دستهبندی دادهها به دستههای مختلف برای تحلیلهای خاص.

-

فیلترینگ دادهها (Data Filtering)

در این مرحله، دادههای غیرضروری حذف شده و فقط دادههای مرتبط و مفید برای تحلیل باقی میمانند.

وظایف اصلی در فیلترینگ دادهها:

-

- حذف دادههای نامرتبط: حذف دادههایی که برای تحلیلها و نیازهای تجاری ضروری نیستند.

- انتخاب دادههای خاص: انتخاب دادههای خاص بر اساس معیارهای تعریفشده.

نقش کلاور در مرحله تبدیل

- طراحی فرآیند تبدیل: ما مسئول طراحی و برنامهریزی فرآیند تبدیل هستیم تا دادهها به درستی پردازش و تبدیل شوند.

- اجرای تبدیلها: اجرای تبدیلهای مورد نیاز بر روی دادهها، شامل تمیز کردن، استانداردسازی، تجمیع و غنیسازی دادهها.

- نظارت بر کیفیت دادهها: نظارت بر کیفیت دادهها در طول فرآیند تبدیل و اطمینان از اینکه دادهها تمیز، دقیق و قابل اعتماد هستند.

- مستندسازی: مستندسازی فرآیندها و تکنیکهای استفادهشده در مرحله تبدیل برای اطمینان از نگهداری و مدیریت صحیح دادهها.

- ارتباط با تیمهای دیگر: ارتباط با تیمهای فنی، مدیریتی و عملیاتی برای فهم و برآورده کردن نیازهای دادهای سازمان.

- بهینهسازی فرآیندها: تحلیل و بهبود فرآیندهای تبدیل دادهها به منظور افزایش کارایی و دقت.

چالشهای مرحله تبدیل

- پیچیدگی دادهها: دادهها ممکن است پیچیده و متنوع باشند که تبدیل آنها را دشوار میکند.

- حجم بالای دادهها: پردازش و تبدیل حجم زیادی از دادهها نیاز به منابع و زمان زیادی دارد.

- کیفیت دادهها: تضمین کیفیت دادهها در طول فرآیند تبدیل یک چالش مهم است.

- هماهنگی با نیازهای تجاری: اطمینان از اینکه دادههای تبدیلشده با نیازهای تجاری و تحلیلی سازمان هماهنگ باشند.

مرحله تبدیل یکی از کلیدیترین مراحل در فرآیند ETL است که تضمین میکند دادهها به صورت صحیح، تمیز و قابل استفاده برای تحلیلها و تصمیمگیریهای تجاری آماده میشوند. این مرحله نقش مهمی در بهبود کیفیت و قابلیت استفاده از دادهها دارد.

3. مرحله سوم – بارگذاری (Load)

مرحله بارگذاری (Load) سومین و آخرین بخش از فرآیند ETL (Extract, Transform, Load) است. در این مرحله، دادههای تبدیل شده به مقصد نهایی خود منتقل میشوند، که معمولاً یک انبار داده (Data Warehouse) یا دیتابیس تحلیلی است. هدف اصلی این مرحله، اطمینان از ذخیرهسازی دادهها به صورت کارآمد و قابل دسترس برای تحلیلها و گزارشگیریهای بعدی است.

مراحل و وظایف اصلی در مرحله بارگذاری:

-

انتخاب استراتژی بارگذاری

قبل از بارگذاری دادهها، باید استراتژی مناسبی برای این کار انتخاب شود. دو نوع اصلی استراتژی بارگذاری وجود دارد:

-

- بارگذاری کامل (Full Load): در این روش، کل دادهها به صورت کامل به مقصد نهایی بارگذاری میشوند. این روش معمولاً در شروع پروژهها یا در زمانهای خاصی که نیاز به بازسازی کامل دادهها وجود دارد، استفاده میشود.

- بارگذاری افزایشی (Incremental Load): در این روش، فقط دادههای جدید یا تغییر یافته به مقصد نهایی بارگذاری میشوند. این روش به منظور کاهش حجم دادههای بارگذاری شده و افزایش کارایی استفاده میشود.

-

انتقال دادهها

در این مرحله، دادههای تبدیلشده به مقصد نهایی منتقل میشوند. انتقال دادهها ممکن است به صورت دستهای (Batch Processing) یا در زمان واقعی (Real-Time Processing) انجام شود.

وظایف اصلی در انتقال دادهها:

-

- انتقال دستهای: انتقال دادهها در دستههای بزرگ و در زمانهای مشخص. این روش معمولاً برای بارگذاریهای برنامهریزیشده و در دورههای زمانی منظم استفاده میشود.

- انتقال زمان واقعی: انتقال دادهها به صورت مستمر و به محض وقوع تغییرات. این روش معمولاً برای سیستمهایی که نیاز به بهروزرسانی فوری دادهها دارند، استفاده میشود.

-

مدیریت یکپارچگی دادهها

در این مرحله، اطمینان حاصل میشود که دادهها به صورت صحیح و یکپارچه به مقصد نهایی منتقل شدهاند.

وظایف اصلی در مدیریت یکپارچگی دادهها:

-

- بررسی صحت دادهها: اطمینان از اینکه دادهها به درستی و بدون خطا منتقل شدهاند.

- بررسی جامعیت دادهها: اطمینان از اینکه تمام دادههای مورد نیاز به مقصد نهایی منتقل شدهاند و هیچ دادهای مفقود نشده است.

- مدیریت ناسازگاریها: شناسایی و رفع ناسازگاریها و مشکلات احتمالی در دادهها.

-

بهروزرسانی نماها و شاخصها

پس از انتقال دادهها، نماها (Views) و شاخصها (Indexes) در انبار داده یا دیتابیس تحلیلی بهروزرسانی میشوند تا کارایی پرس و جوها و گزارشگیریها بهبود یابد.

وظایف اصلی در بهروزرسانی نماها و شاخصها:

-

- ایجاد و بهروزرسانی نماها: ایجاد نماهای جدید یا بهروزرسانی نماهای موجود برای سادهسازی و بهبود پرس و جوها.

- ایجاد و بهروزرسانی شاخصها: ایجاد شاخصهای جدید یا بهروزرسانی شاخصهای موجود برای بهبود سرعت دسترسی به دادهها.

-

مستندسازی و نظارت

در این مرحله، فرآیند بارگذاری مستندسازی شده و عملکرد آن نظارت میشود تا اطمینان حاصل شود که دادهها به صورت صحیح و کارآمد بارگذاری شدهاند.

وظایف اصلی در مستندسازی و نظارت:

-

- مستندسازی فرآیندها: ثبت جزئیات فرآیندهای بارگذاری برای استفاده در آینده و بهبود مستمر.

- نظارت بر عملکرد: نظارت بر عملکرد فرآیند بارگذاری و شناسایی و رفع مشکلات احتمالی.

نقش کلاور در مرحله بارگذاری

- طراحی فرآیند بارگذاری: تحلیلگر داده مسئول طراحی و برنامهریزی فرآیند بارگذاری است تا دادهها به درستی و به موقع به مقصد نهایی منتقل شوند.

- نظارت بر انتقال دادهها: نظارت بر انتقال دادهها و اطمینان از اینکه دادهها به صورت صحیح و کامل منتقل شدهاند.

- مدیریت یکپارچگی دادهها: اطمینان از صحت و یکپارچگی دادهها در طول فرآیند بارگذاری.

- مستندسازی: مستندسازی فرآیندها و تکنیکهای استفادهشده در مرحله بارگذاری برای اطمینان از نگهداری و مدیریت صحیح دادهها.

- ارتباط با تیمهای دیگر: ارتباط با تیمهای فنی، مدیریتی و عملیاتی برای فهم و برآورده کردن نیازهای دادهای سازمان.

- بهینهسازی فرآیندها: تحلیل و بهبود فرآیندهای بارگذاری دادهها به منظور افزایش کارایی و دقت.

چالشهای مرحله بارگذاری

- حجم بالای دادهها: بارگذاری حجم زیادی از دادهها نیاز به منابع و زمان زیادی دارد.

- زمانبندی دقیق: اطمینان از اینکه فرآیند بارگذاری به موقع و در زمانهای مناسب انجام شود.

- مدیریت خطاها: شناسایی و رفع خطاهای احتمالی در طول فرآیند بارگذاری.

- هماهنگی با نیازهای تجاری: اطمینان از اینکه دادههای بارگذاریشده با نیازهای تجاری و تحلیلی سازمان هماهنگ باشند.

مرحله بارگذاری یکی از کلیدیترین مراحل در فرآیند ETL است که تضمین میکند دادهها به صورت صحیح و کامل به مقصد نهایی منتقل شده و برای تحلیلها و گزارشگیریهای بعدی آماده میشوند. این مرحله نقش مهمی در ایجاد یک انبار داده یکپارچه و قابل اعتماد دارد.

ابزارهای مورد استفاده در فرآیند ETL

1. Informatica – PowerCenter

معرفی: Informatica PowerCenter یک پلتفرم ETL (Extract, Transform, Load) بسیار قدرتمند و انعطافپذیر است که برای انتقال، تغییر و بارگذاری دادهها در سیستمهای مختلف استفاده میشود.

مزایا:

- کاربری گسترده و پشتیبانی از انواع منابع داده.

- عملکرد بالا و مقیاسپذیری.

- ابزارهای غنی برای توسعه، مدیریت و مانیتورینگ فرآیندهای ETL.

معایب:

- هزینه بالای لایسنس.

- پیچیدگی و نیاز به تخصص بالا برای استفاده و پیادهسازی.

2. IBM – Infosphere Information Server

معرفی: IBM InfoSphere Information Server یک پلتفرم جامع برای مدیریت دادهها است که شامل ابزارهای ETL، کیفیت داده، و پروفایلینگ داده میشود.

مزایا:

- یکپارچگی بالا با دیگر محصولات IBM.

- ابزارهای قدرتمند برای کیفیت و مدیریت دادهها.

- پشتیبانی گسترده از منابع داده و فناوریهای مختلف.

معایب:

- هزینه بالا.

- پیچیدگی نصب و مدیریت.

3. Oracle Data Integrator (ODI)

معرفی: Oracle Data Integrator یک ابزار ETL است که از معماری ELT (Extract, Load, Transform) استفاده میکند و برای یکپارچهسازی دادهها از منابع مختلف طراحی شده است.

مزایا:

- عملکرد بالا با استفاده از معماری ELT.

- یکپارچگی خوب با محصولات اوراکل.

- قابلیتهای پیشرفته برای تغییر و بارگذاری دادهها.

معایب:

- پیچیدگی در یادگیری و استفاده.

- نیاز به تخصص در زمینه محصولات اوراکل.

4. Microsoft – SQL Server Integration Services (SSIS)

معرفی: SSIS یک ابزار ETL است که بخشی از SQL Server است و برای انتقال و تغییر دادهها در سازمانها استفاده میشود.

مزایا:

- ادغام کامل با SQL Server.

- رابط کاربری گرافیکی کاربرپسند.

- هزینه نسبتا پایین در مقایسه با دیگر ابزارها.

معایب:

- محدودیت در پشتیبانی از منابع داده غیر مایکروسافت.

- نیاز به دانش SQL Server برای استفاده بهینه.

5. Talend – Talend Open Studio for Data Integration

معرفی: Talend Open Studio یک ابزار ETL منبع باز است که برای یکپارچهسازی دادهها و تغییر و انتقال دادهها استفاده میشود.

مزایا:

- منبع باز و رایگان.

- پشتیبانی از انواع منابع داده.

- رابط کاربری گرافیکی کاربرپسند.

معایب:

- عملکرد پایینتر نسبت به ابزارهای تجاری.

- نیاز به تخصص برای استفاده و توسعه.

6. Pentaho Data Integration

معرفی: Pentaho Data Integration که به Kettle نیز معروف است، یک ابزار ETL منبع باز است که برای تغییر و بارگذاری دادهها استفاده میشود.

مزایا:

- منبع باز و رایگان.

- پشتیبانی از انواع منابع داده.

- ابزارهای قدرتمند برای تغییر دادهها.

معایب:

- پیچیدگی در پیادهسازی و مدیریت.

- نیاز به تخصص برای استفاده بهینه.

7. SAS – Data Integration Studio

معرفی: SAS Data Integration Studio یک ابزار ETL است که بخشی از مجموعه نرمافزارهای SAS میباشد و برای مدیریت و تغییر دادهها استفاده میشود.

مزایا:

- یکپارچگی خوب با دیگر محصولات SAS.

- ابزارهای قدرتمند برای تحلیل و تغییر دادهها.

- عملکرد بالا و مقیاسپذیری.

معایب:

- هزینه بالا.

- نیاز به تخصص در زمینه محصولات SAS.

8. SAP – BusinessObjects Data Integrator

معرفی: SAP BusinessObjects Data Integrator یک ابزار ETL است که بخشی از مجموعه نرمافزارهای SAP میباشد و برای تغییر و بارگذاری دادهها استفاده میشود.

مزایا:

- یکپارچگی خوب با محصولات SAP.

- ابزارهای قدرتمند برای تغییر و مدیریت دادهها.

- عملکرد بالا و مقیاسپذیری.

معایب:

- هزینه بالا.

- پیچیدگی در پیادهسازی و مدیریت.

اولویتبندی بر اساس کارایی:

- Informatica – PowerCenter

- IBM – Infosphere Information Server

- Oracle Data Integrator (ODI)

- Microsoft – SQL Server Integration Services (SSIS)

- SAS – Data Integration Studio

- SAP – BusinessObjects Data Integrator

- Talend – Talend Open Studio for Data Integration

- Pentaho Data Integration

این اولویتبندی بر اساس میزان عملکرد، مقیاسپذیری، یکپارچگی با دیگر محصولات، و هزینه صورت گرفته است.

نقش کلاور در کل فرآیند ETL

- طراحی فرآیند ETL: ما مسئول طراحی و برنامهریزی فرآیند ETL هستیم تا اطمینان حاصل کنیم که دادهها به درستی استخراج، تبدیل و بارگذاری میشوند.

- جمعآوری نیازهای کسبوکار: ما نیازهای کسبوکار را جمعآوری میکنیم تا اطمینان حاصل کند که فرآیند ETL مطابق با نیازهای سازمان است.

- نظارت بر کیفیت دادهها: ما مسئول نظارت بر کیفیت دادهها در طول فرآیند ETL هستیم و باید اطمینان حاصل کنیم که دادهها تمیز و قابل اعتماد هستند.

- تست و اعتبارسنجی: ما فرآیند ETL را تست و اعتبارسنجی میکنیم تا اطمینان حاصل شود که دادهها به درستی پردازش و بارگذاری میشوند.

- مستندسازی: مستندسازی فرآیندها و ابزارهای استفاده شده در فرآیند ETL برای اطمینان از نگهداری و مدیریت صحیح دادهها.

- ارتباط با تیمهای دیگر: ما باید با تیمهای فنی، مدیریتی و عملیاتی ارتباط برقرار کنیم تا نیازهای دادهای سازمان را به درستی فهمیده و برآورده کند.

شرکت تحلیل داده کلاور، با بهرهگیری از تکنولوژیهای پیشرفته و تیم متخصصان مجرب، خدمات جامع ETL (Extract, Transform, Load) را به مشتریان خود ارائه میدهد. ما در کلاور با استخراج دقیق دادهها از منابع متعدد، تبدیل و استانداردسازی آنها به فرمتهای مناسب و بارگذاری سریع و امن در انبارهای داده، امکان تحلیلهای عمیق و تصمیمگیریهای استراتژیک را برای کسبوکارها فراهم میکنیم. خدمات ما شامل شناسایی منابع داده، تمیز کردن و غنیسازی دادهها، مدیریت یکپارچگی و انتقال دادهها به صورت موثر و بهینه است. با کلاور، دادههای خود را به داراییهای ارزشمند تبدیل کنید و بهرهوری سازمان خود را افزایش دهید.